Windows 11 GPU 개발환경 설정 (ver. 2025.04)

Page content

개요

- 내 PC의 GPU 환경 확인 부터 딥러닝 설치까지, Windows 11 환경에서 진행

- 실패 없이 한번에 설치가 되었다!

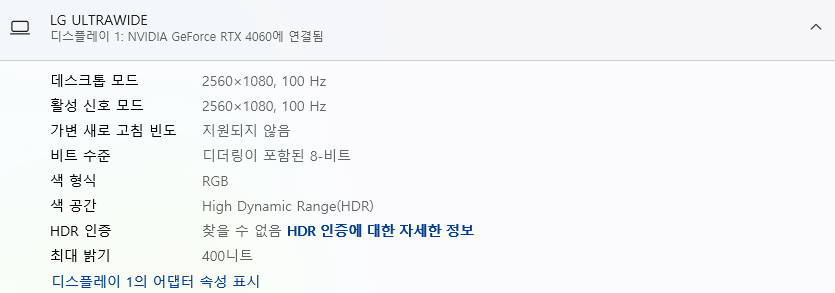

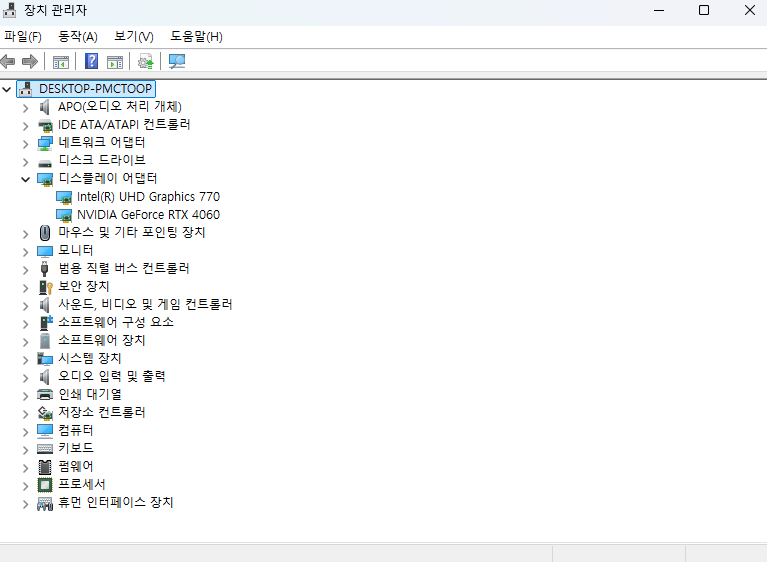

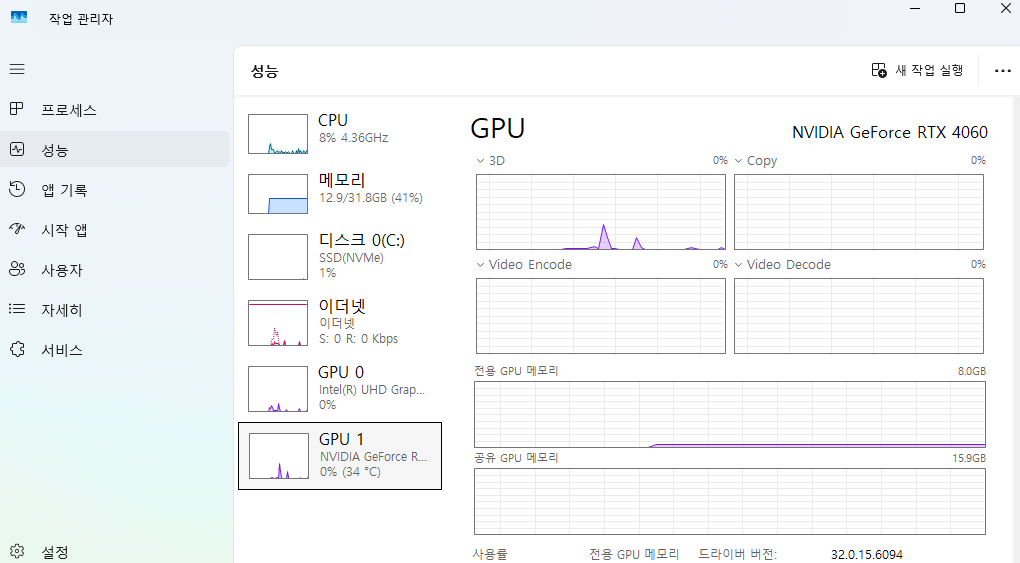

내 PC의 GPU 환경 확인

- 시스템 > 디스플레이 > 고급 디스플레이에서 확인

- 장치 관리자에서 확인

- 작업 관리자 > 성능 탭에서 확인

- 현재 NVIDIA GeForce RTX 4060 그래픽 카드 사용중인 것 확인

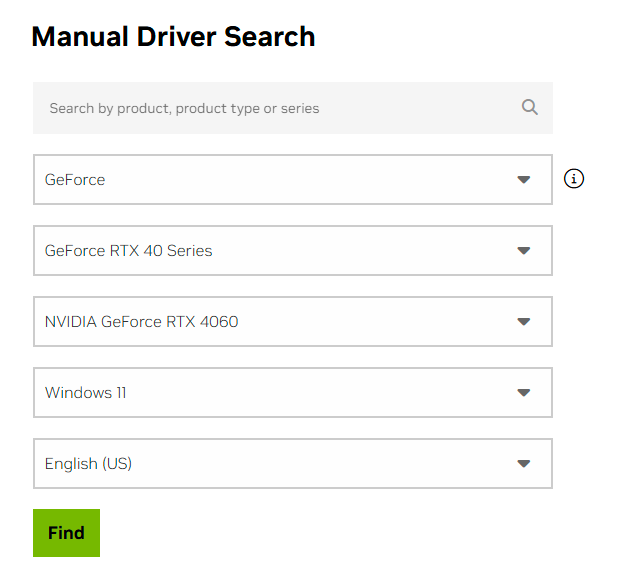

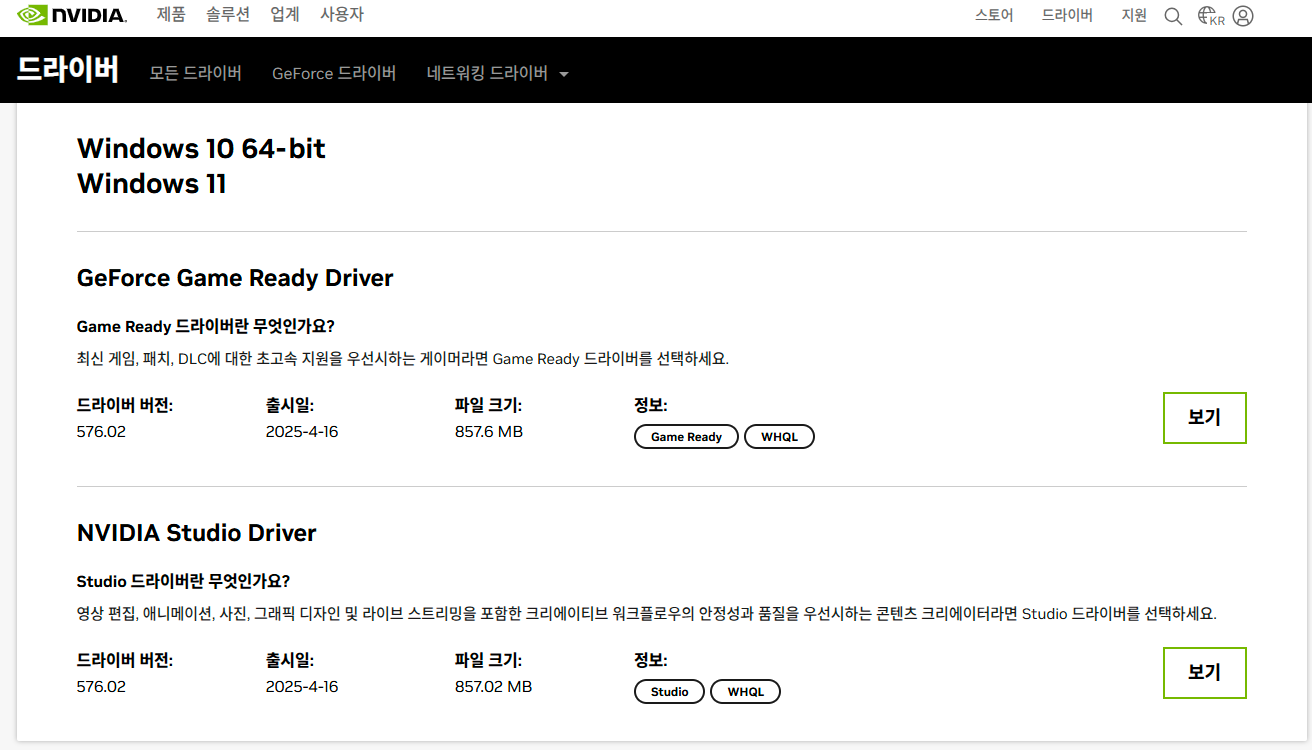

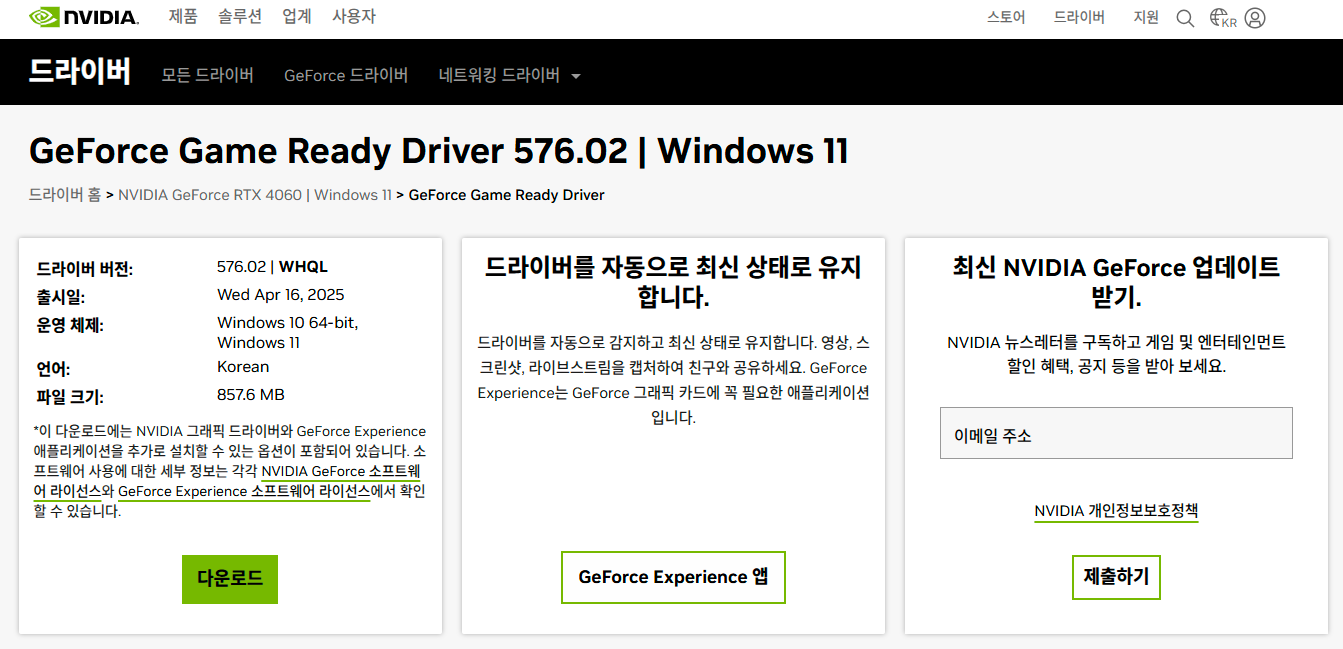

NVIDIA Driver 설치

- GeForce Game Ready Driver 다운로

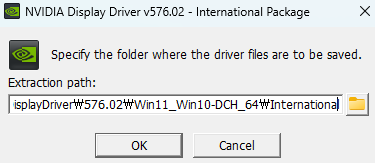

- 다운로드 받은 파일 관리자 권한으로 실행 후, 다음 그림에서 OK 버튼 클릭

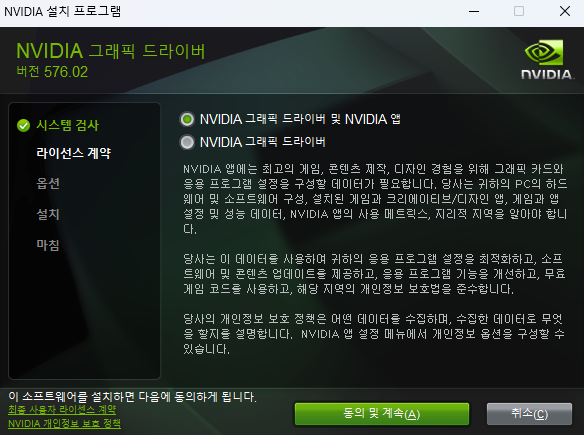

- 동의 및 계속 버튼 클릭

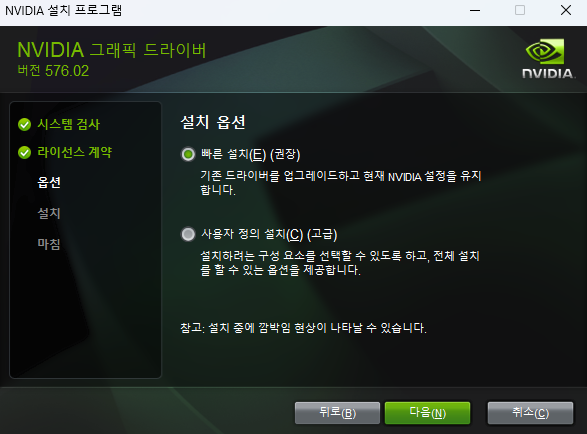

- 다음 버튼 클릭

- 설치 중

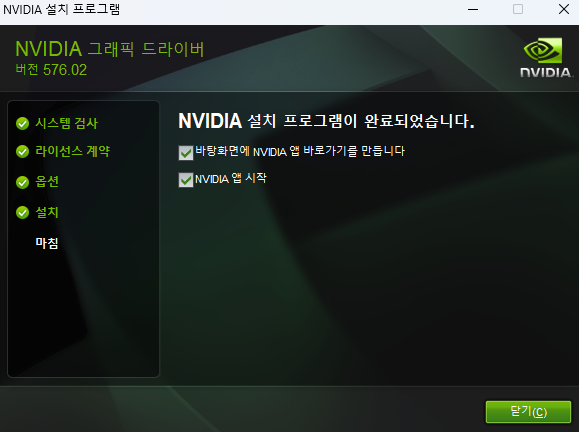

- 설치 완료

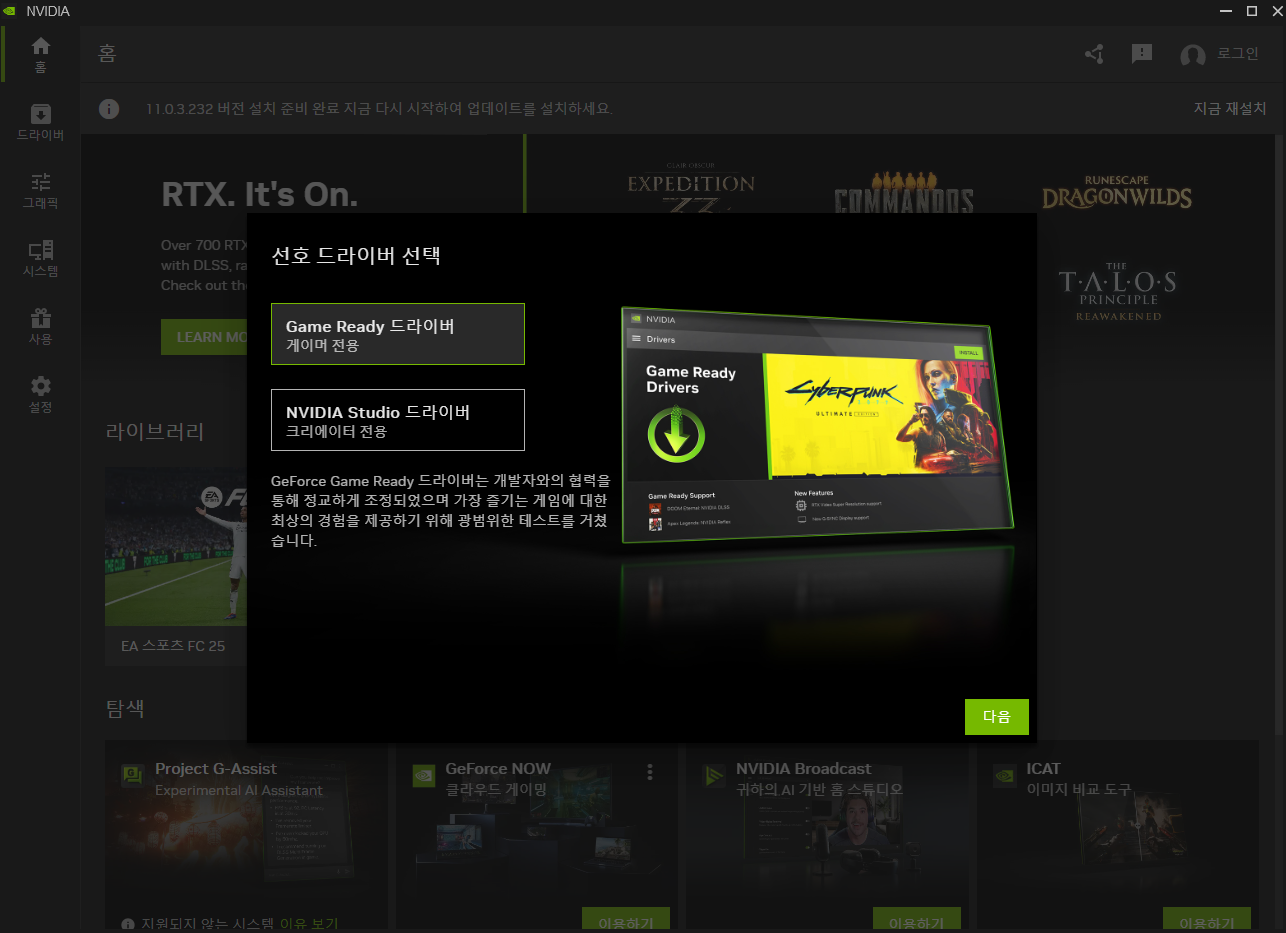

- 다음 화면에서 Game Ready 드라이버 선택

- 다음 선택

- 완료

CUDA Toolkit 설치

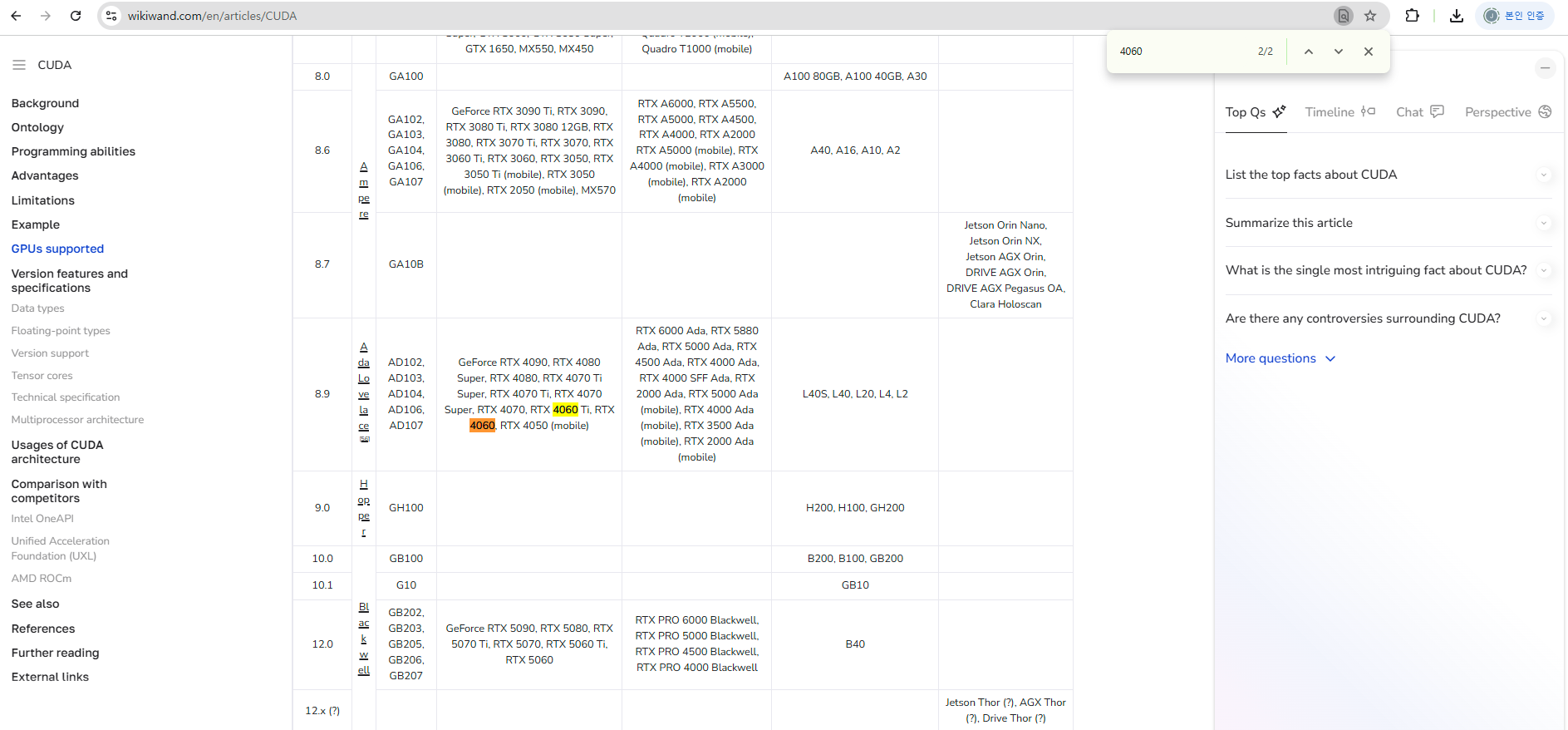

CUDA 지원, 성능, 코어 수 확인

- 링크 확인 : https://www.wikiwand.com/en/articles/CUDA

- 검색 통해서 빠르게 확인

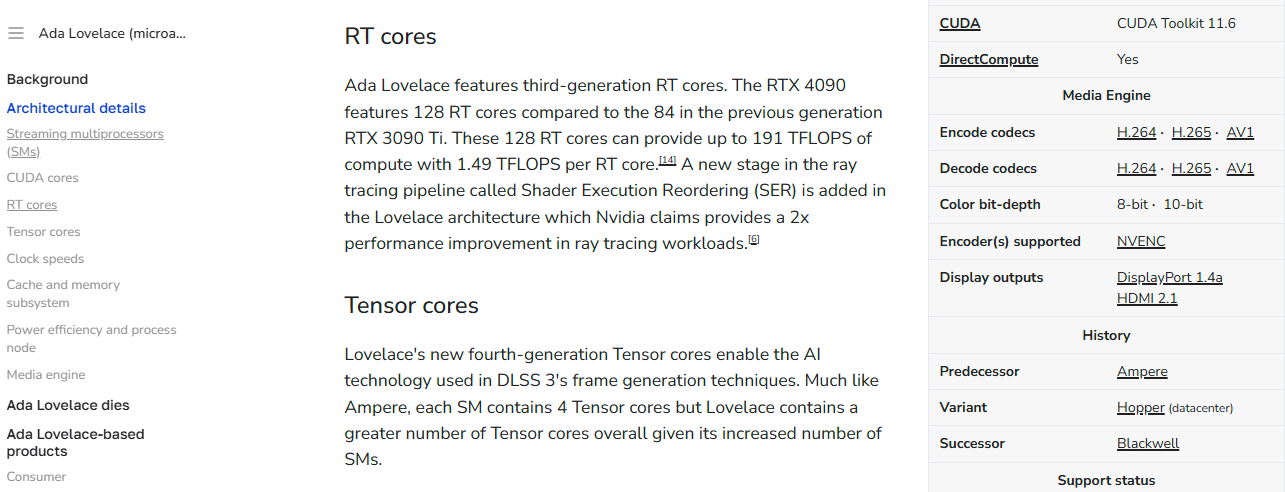

- 필자의 아키텍쳐 : Ada Lovelace (microarchitecture)

- 필자의 CUDA 버전은 8.9인 것 확인

- 필자의 CUDA Toolkit은 11.6인 것 확인

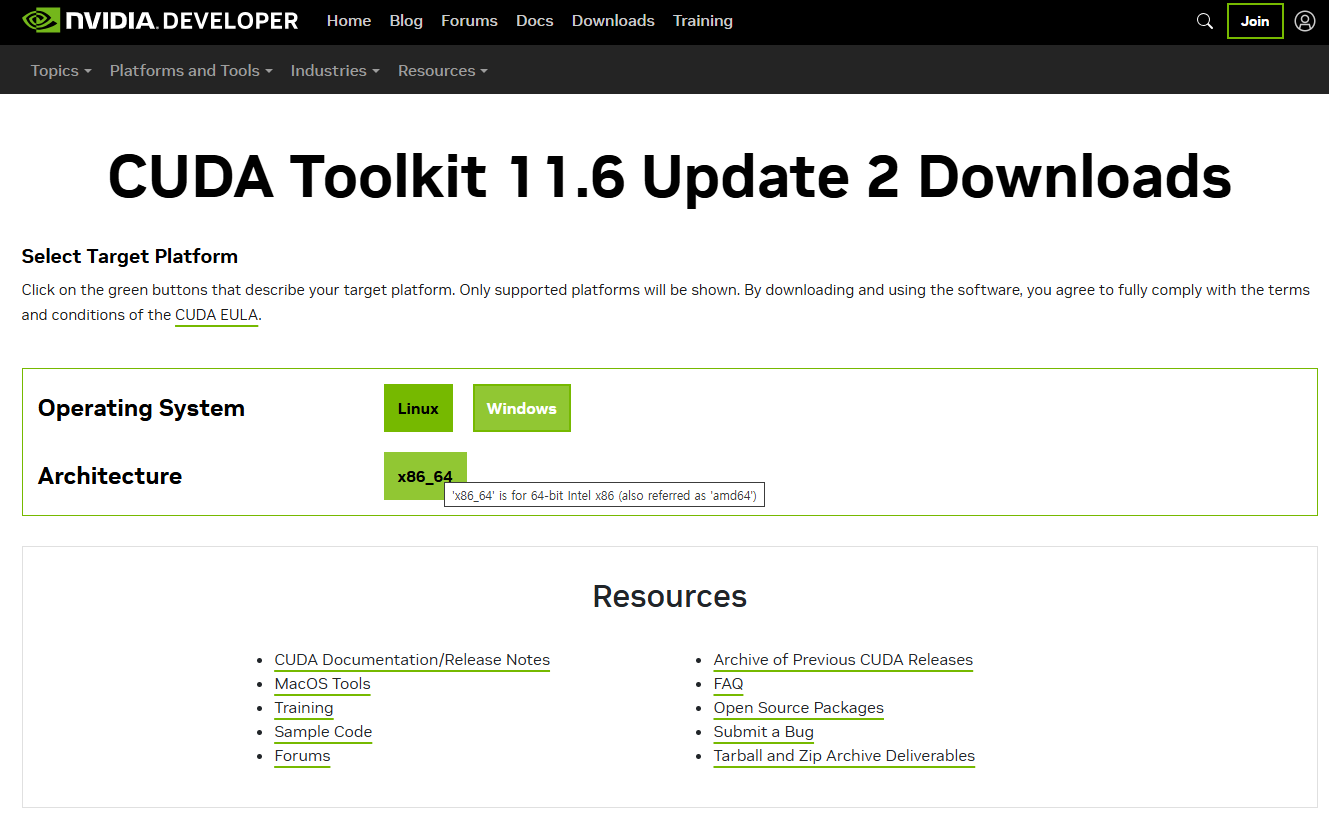

CUDA Toolkit 확인 및 설치

- 다음 그림에서 버전에 맞는 CUDA Toolkit 확인

- 링크 : https://developer.nvidia.com/cuda-toolkit-archive

- 필자는 CUDA Toolkit 11.6.2 버전 선택

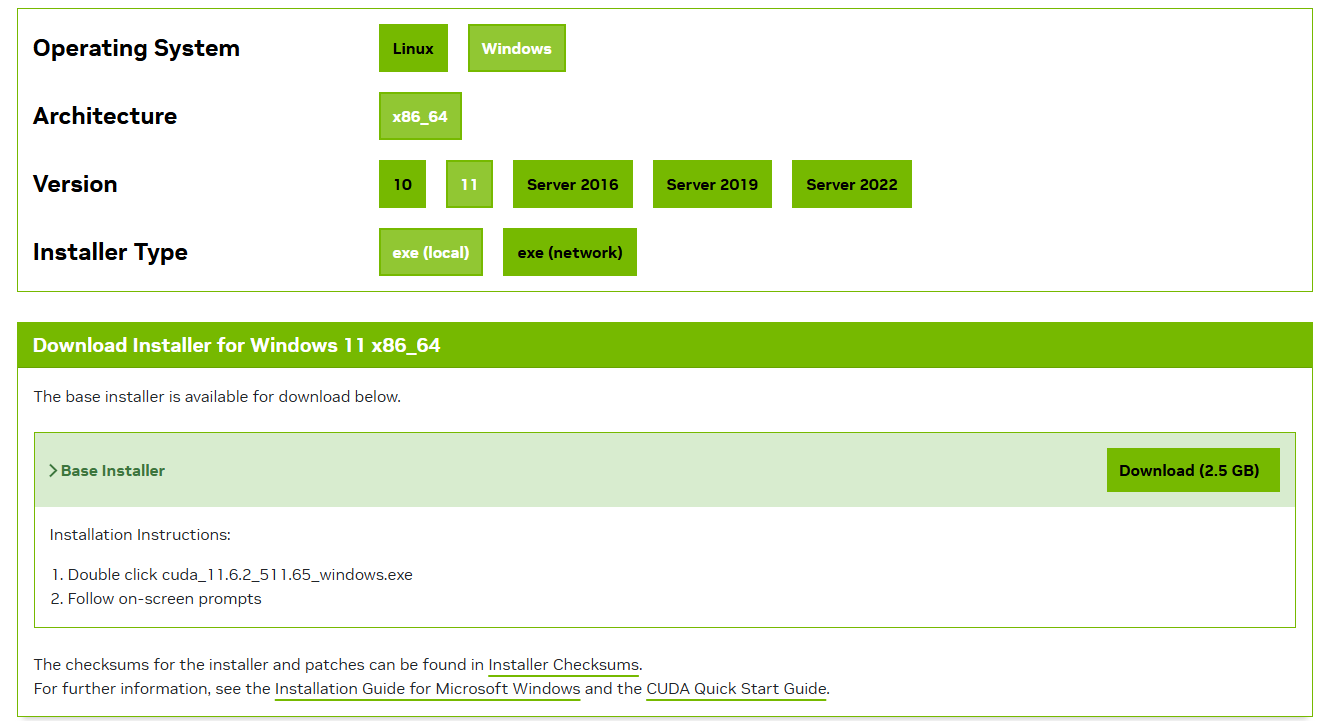

- Windows 선택

- x86_64도 64비트라고 명시가 되어 있으니 고민 없이 선택

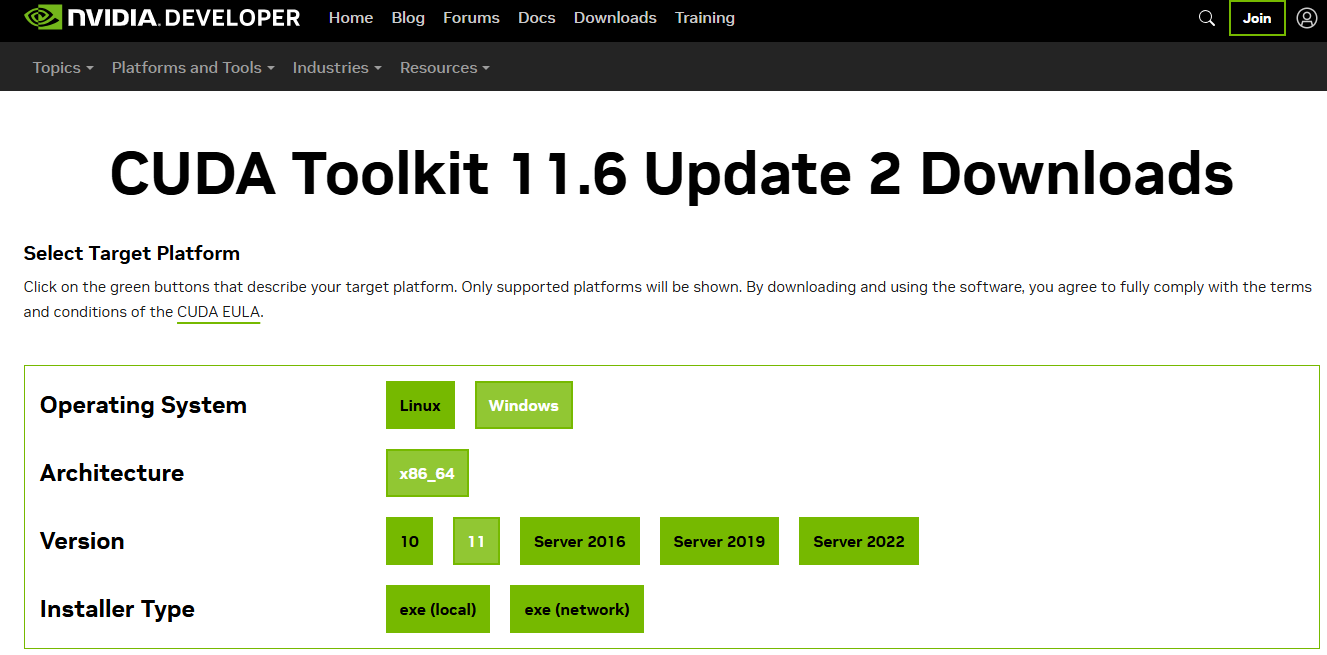

- 필자의 PC는 현재 Windows 11이니, 11 선택

- Installer Type도 exe 선택

- Download (2.5 GB) 클릭

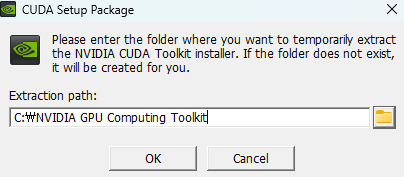

- 설치 파일 관리자 권한으로 실행, 설치 위치 변경 가능

- NVIDIA GPU Computing Toolkit 폴더 먼저 만든 후, OK 버튼 클릭

- C 드라이브에 다음과 같이 지정한다.

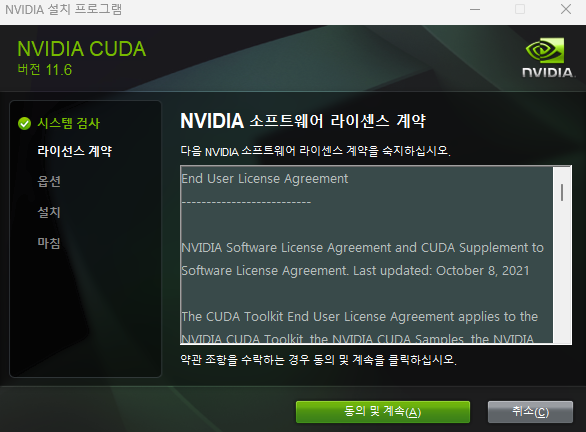

- 설치 프로그램 동작 시작, 동의 및 계속 버튼 클릭

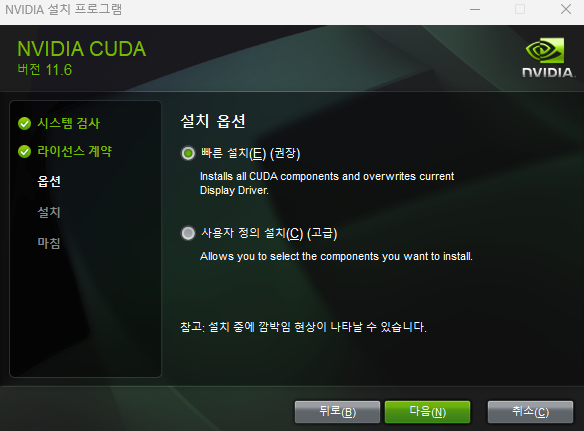

- 빠른 설치 옵션 확인 및 다음 버튼 클릭

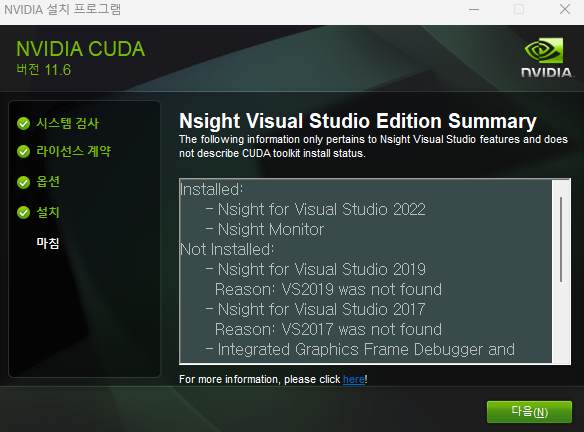

- 다음 버튼 클릭

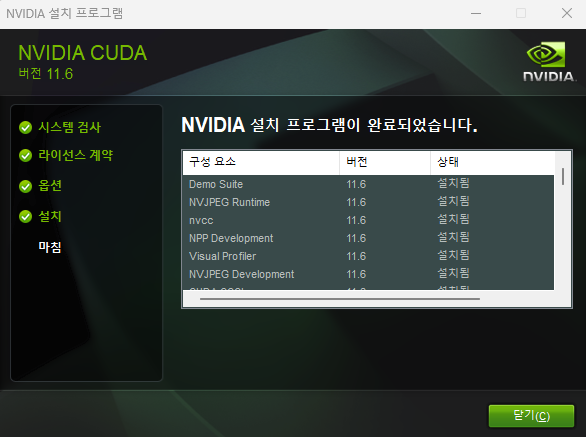

- 닫기

-

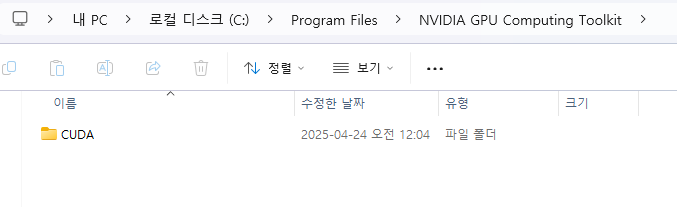

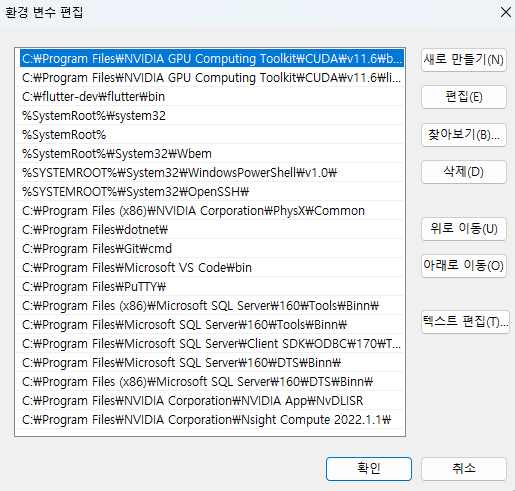

정상적으로 설치가 되었는지 확인 위해 시스템 환경 변수 확인

- 자동으로 C 드라이브 > Program Files > NVIDIA GPU Computing Toolkit 폴더가 만들어진다.

cuDNN 설치

- 사전에 회원가입 진행 (https://developer.nvidia.com/login)

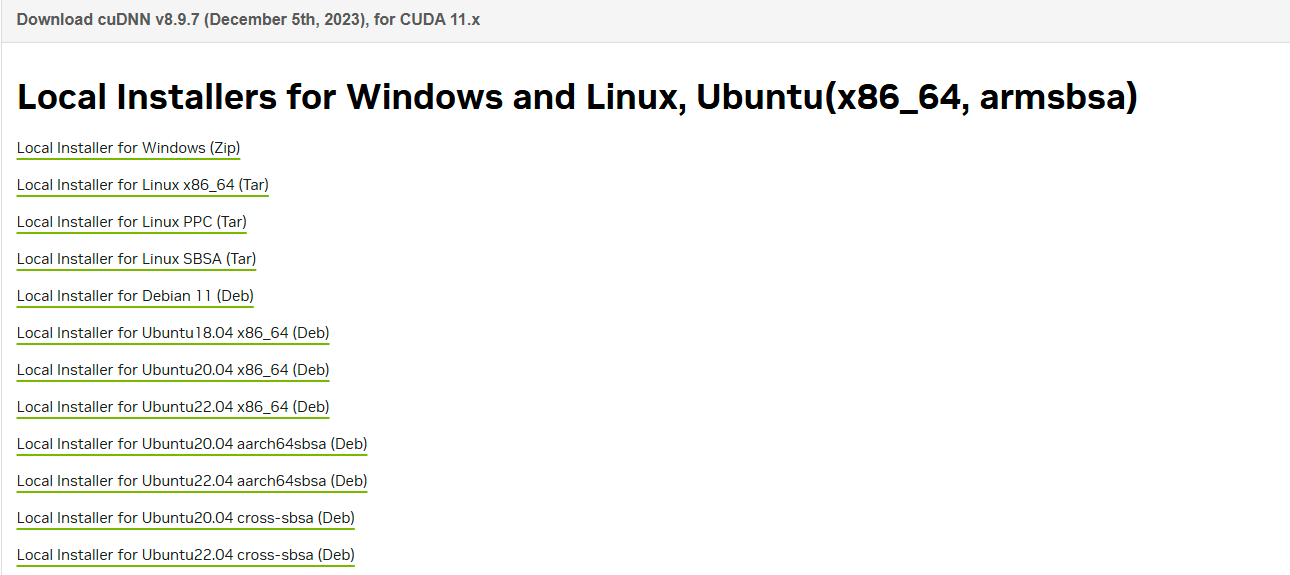

- 링크 : https://developer.nvidia.com/rdp/cudnn-archive

- CUDA 11.x 버전 Windows (Zip) 다운로드

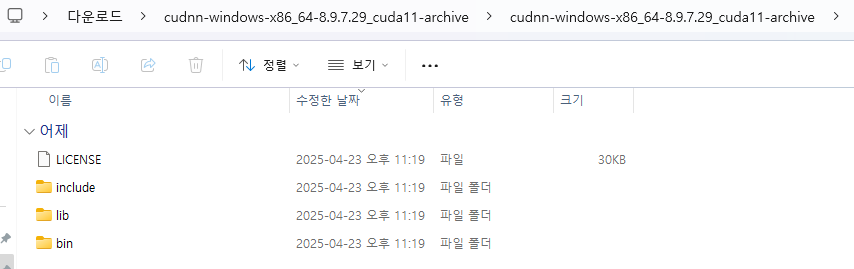

- 압축파일을 풀면 3개의 폴더가 나온다. 3개의 폴더를 모두 복사한다.

- 다음 경로에 복사 붙이기 한다.

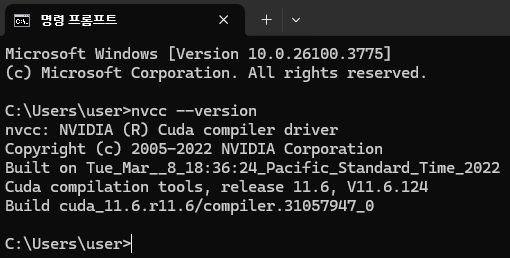

- 버전 확인

C:\Users\user>nvcc --version

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2022 NVIDIA Corporation

Built on Tue_Mar__8_18:36:24_Pacific_Standard_Time_2022

Cuda compilation tools, release 11.6, V11.6.124

Build cuda_11.6.r11.6/compiler.31057947_0

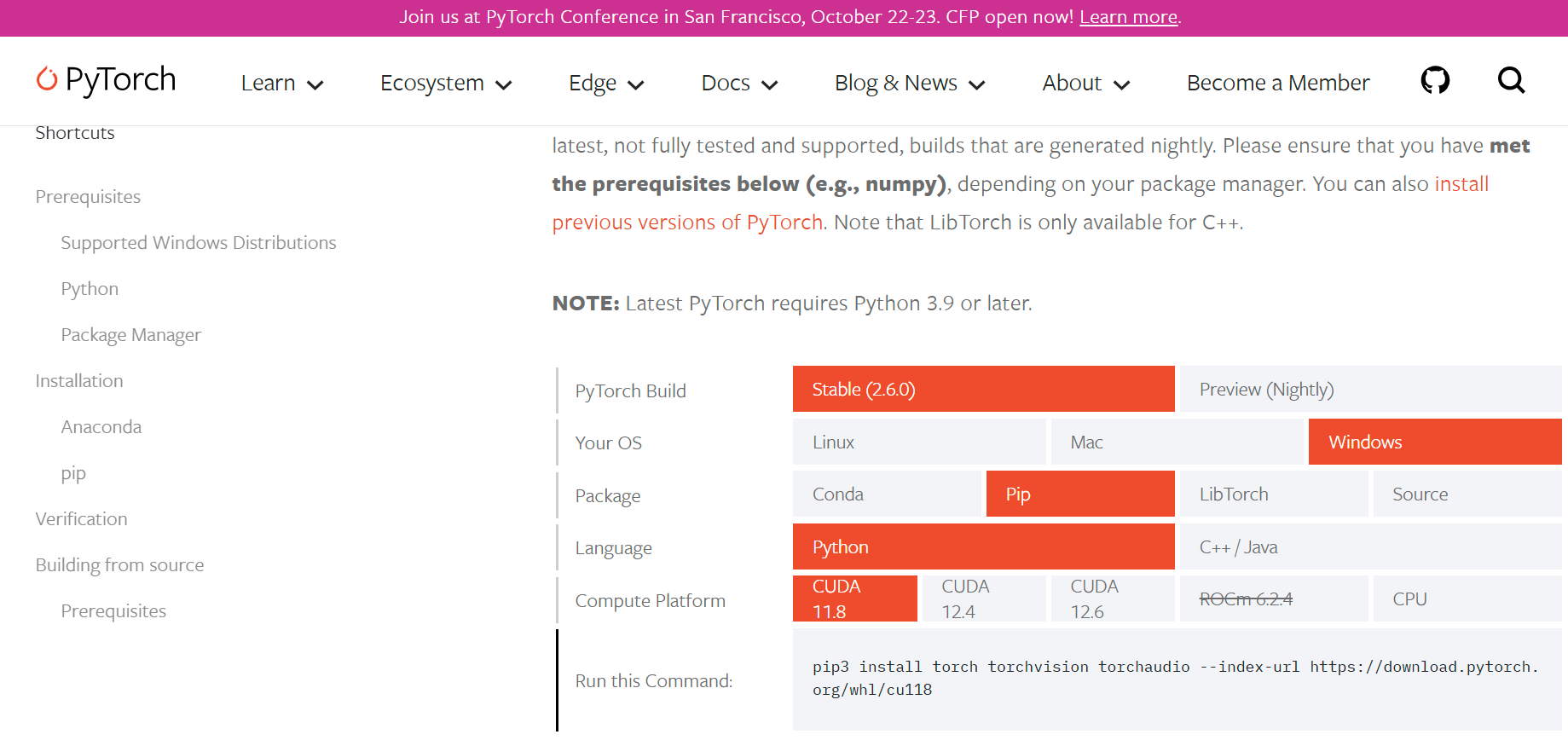

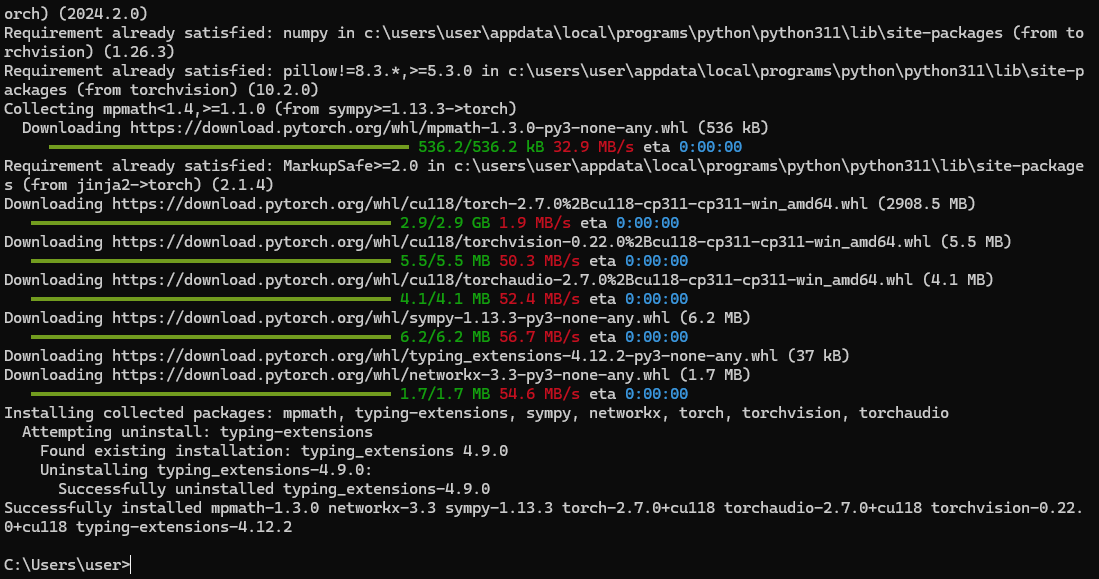

PyTorch 설치

- 필자는 pip으로 설치를 할 예정이다.

$ pip3 --version

pip 23.2.1 from C:\Users\user\AppData\Local\Programs\Python\Python311\Lib\site-packages\pip (python 3.11)

- 사이트 확인

- CUDA 11.8 버전 확인

- 해당 코드 그대로 복사 붙이기 한다.

$ pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

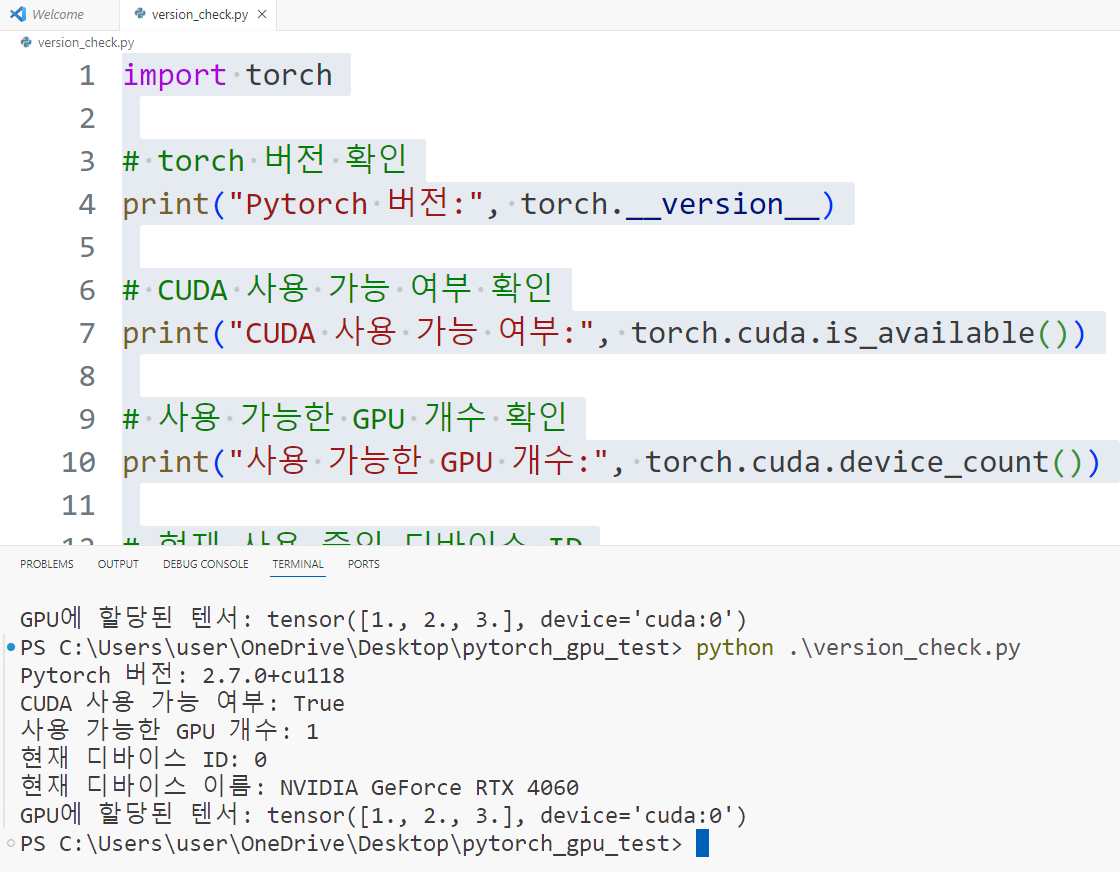

코드 테스트

- 코드는 다음과 같다.

import torch

# torch 버전 확인

print("Pytorch 버전:", torch.__version__)

# CUDA 사용 가능 여부 확인

print("CUDA 사용 가능 여부:", torch.cuda.is_available())

# 사용 가능한 GPU 개수 확인

print("사용 가능한 GPU 개수:", torch.cuda.device_count())

# 현재 사용 중인 디바이스 ID

print("현재 디바이스 ID:", torch.cuda.current_device())

# 현재 디바이스 이름

print("현재 디바이스 이름:", torch.cuda.get_device_name(torch.cuda.current_device()))

# 텐서를 GPU에 할당해보기

x = torch.tensor([1.0, 2.0, 3.0]).to('cuda')

print("GPU에 할당된 텐서:", x)

- 결과는 다음과 같이 나왔다.