R 텍스트 마이닝 1일차 - 빅카인즈 데이터 수집

Page content

Step 01 - 빅카인즈 접속 후, 데이터 내려받기

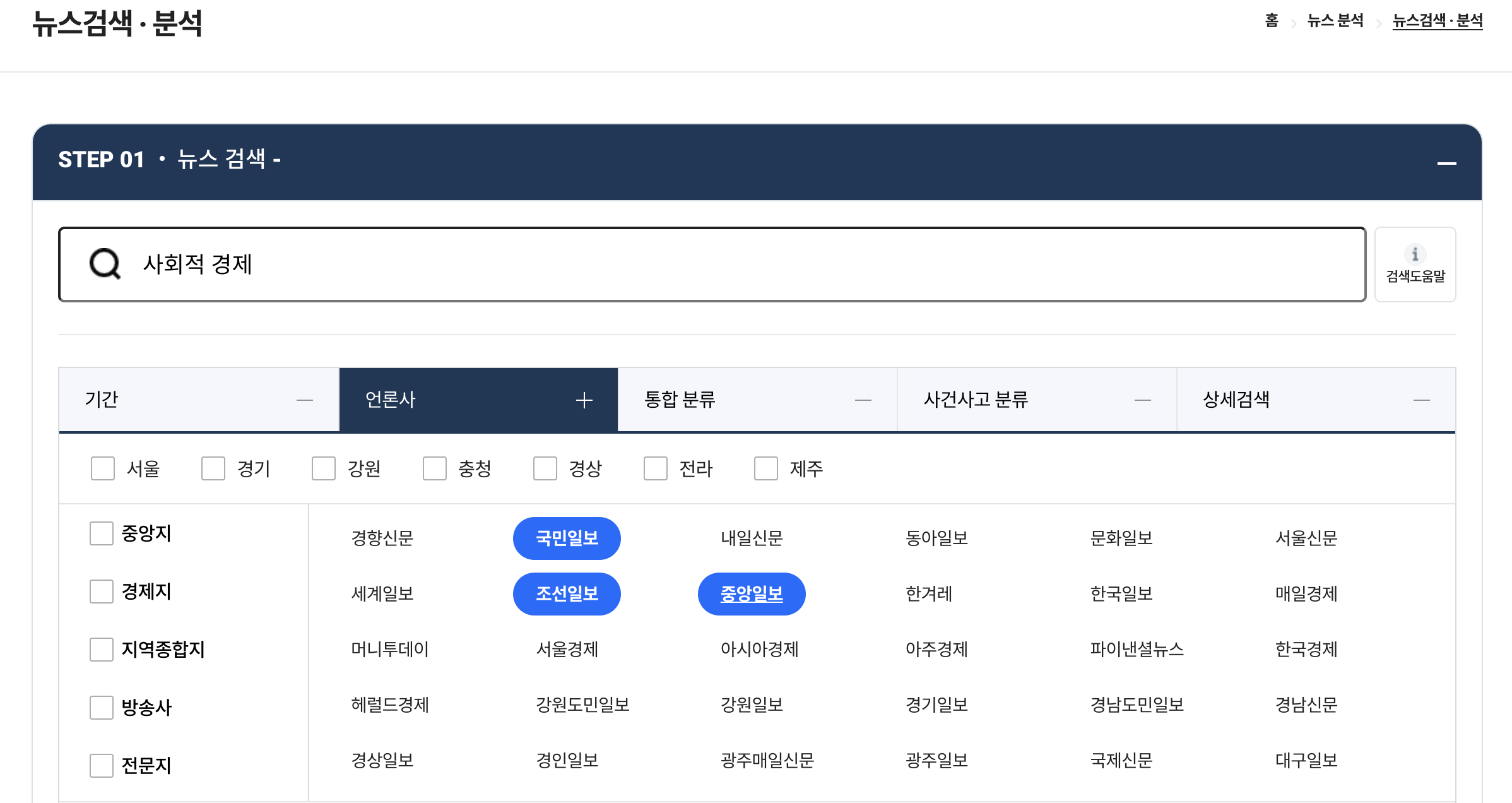

- 싸이트 : https://www.bigkinds.or.kr/v2/news/index.do

- 해당 싸이트에서 키워드를 입력 한다.

- 이 때, 기간, 신문사 등을 선택할 수 있다.

- 필자는 키워드는 ‘사회적 경제’ 신문사는 국민일보, 조선일보, 중앙일보를 선택한다.

- 하단으로 내려 적용하기 버튼을 클릭한다.

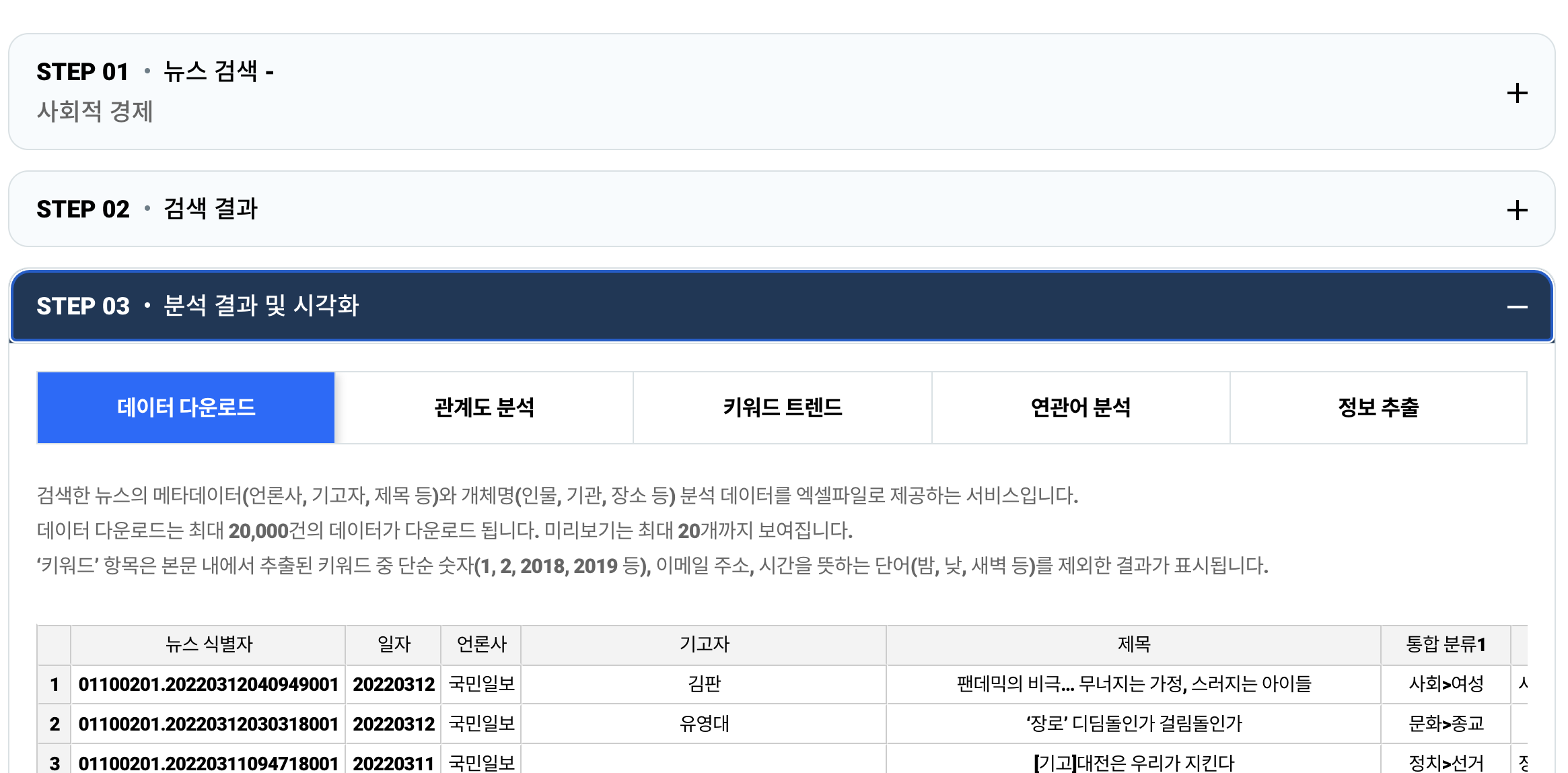

- Step 03 - 분석 결과 및 시각화 탭을 클릭한다.

- 데이터 다운로드 탭 하단에 엑셀 다운로드 버튼을 클릭한다.

- 해당 파일에는 본문이 있지만, 보통 200자 내외로 짧게 요약이 되어 있다.

Step 02 - 웹 크롤링 소스 코드 작성을 위한 사전 준비

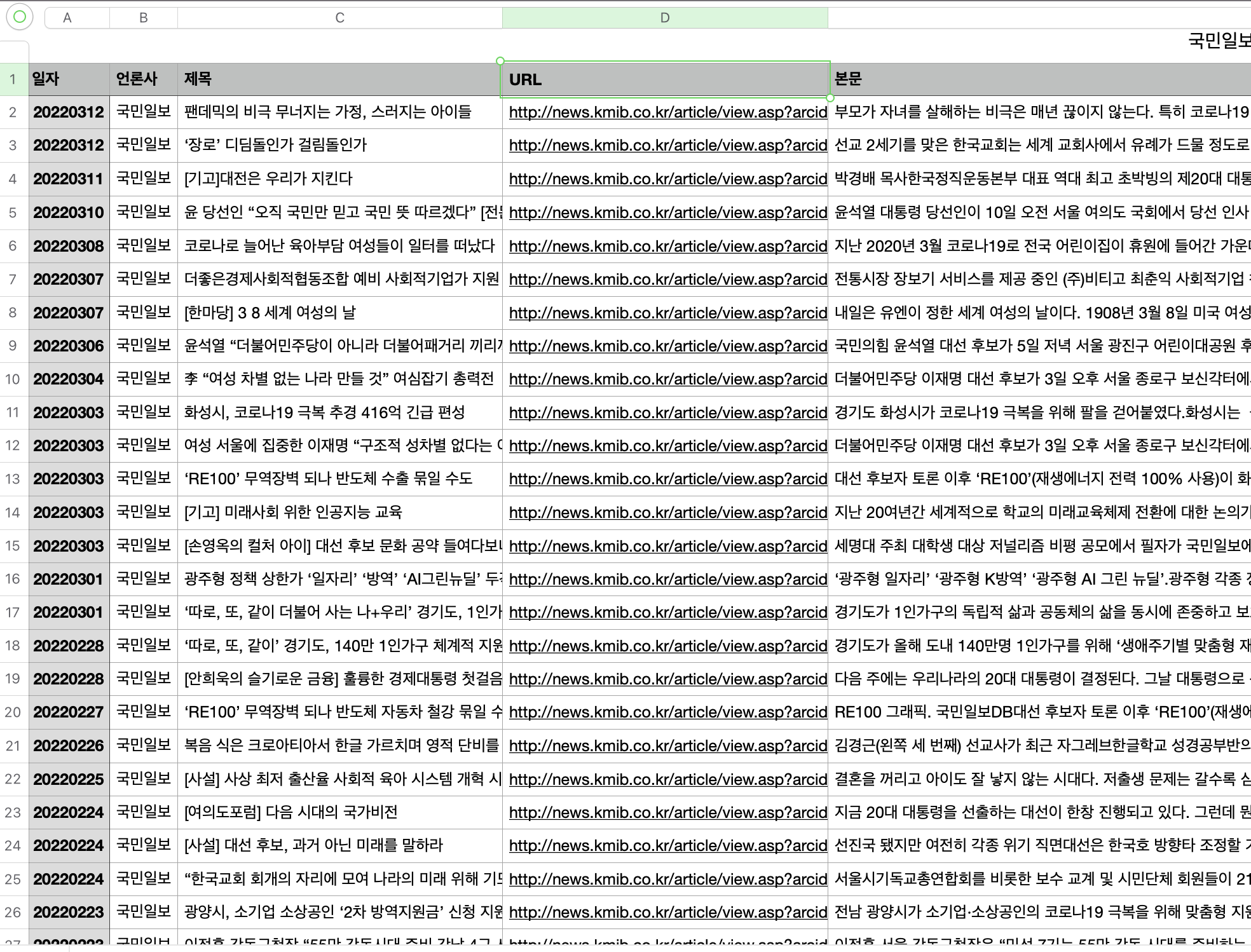

- 먼저 기 다운로드 된 파일을 불러온다.

- 전체 데이터에서 필요한 컬럼만 재추출한다.

> library(dplyr)

> library(readxl)

> raw_df = read_excel("data/NewsResult_20211213-20220313.xlsx", sheet = 1)

> raw_df2 = raw_df %>% select(일자, 언론사, 제목, URL)

> raw_df2 %>% group_by(언론사) %>% summarise(n = n())

# A tibble: 3 × 2

언론사 n

<chr> <int>

1 국민일보 180

2 조선일보 115

3 중앙일보 256

- 각 신문사별로 나눠서 객체를 저장한다. 여기에서는 국민일보만 추출하는 코드를 예시로 하였다.

> kmib_df = raw_df2 %>% filter(언론사 == "국민일보")

> head(kmib_df, 3)

# A tibble: 3 × 4 일자 언론사 제목 URL

<chr> <chr> <chr> <chr>

1 20220312 국민일보 팬데믹의 비극 무너지는 가정, 스러지는 아이들 http://news.kmib.co…

2 20220312 국민일보 ‘장로’ 디딤돌인가 걸림돌인가 http://news.kmib.co…

3 20220311 국민일보 [기고]대전은 우리가 지킨다 http://news.kmib.co…

- 이번에는 URL만 추출하여 특이점이 있는지 확인한다.

- 전체적으로 주소는 비슷하다.

- 몇몇 주소에서는

&cp=kd같은 문자가 더 추가된 것을 확인할 수 있다. - 서로 다른 싸이트에서 본문의 위치 등이 동일한지 다른지 확인할 필요가 있다. (확인 결과, 차이는 없다!)

> kmib_df$URL[1:5]

[1] "http://news.kmib.co.kr/article/view.asp?arcid=0924235144&code=11131100"

[2] "http://news.kmib.co.kr/article/view.asp?arcid=0924235120&code=23111111"

[3] "http://news.kmib.co.kr/article/view.asp?arcid=0016856942&code=61221514&cp=kd"

[4] "http://news.kmib.co.kr/article/view.asp?arcid=0016853803&code=61111711&cp=kd"

[5] "http://news.kmib.co.kr/article/view.asp?arcid=0016847353&code=61131111&cp=kd"

Step 03 - 웹 크롤링 본문 내용 발췌

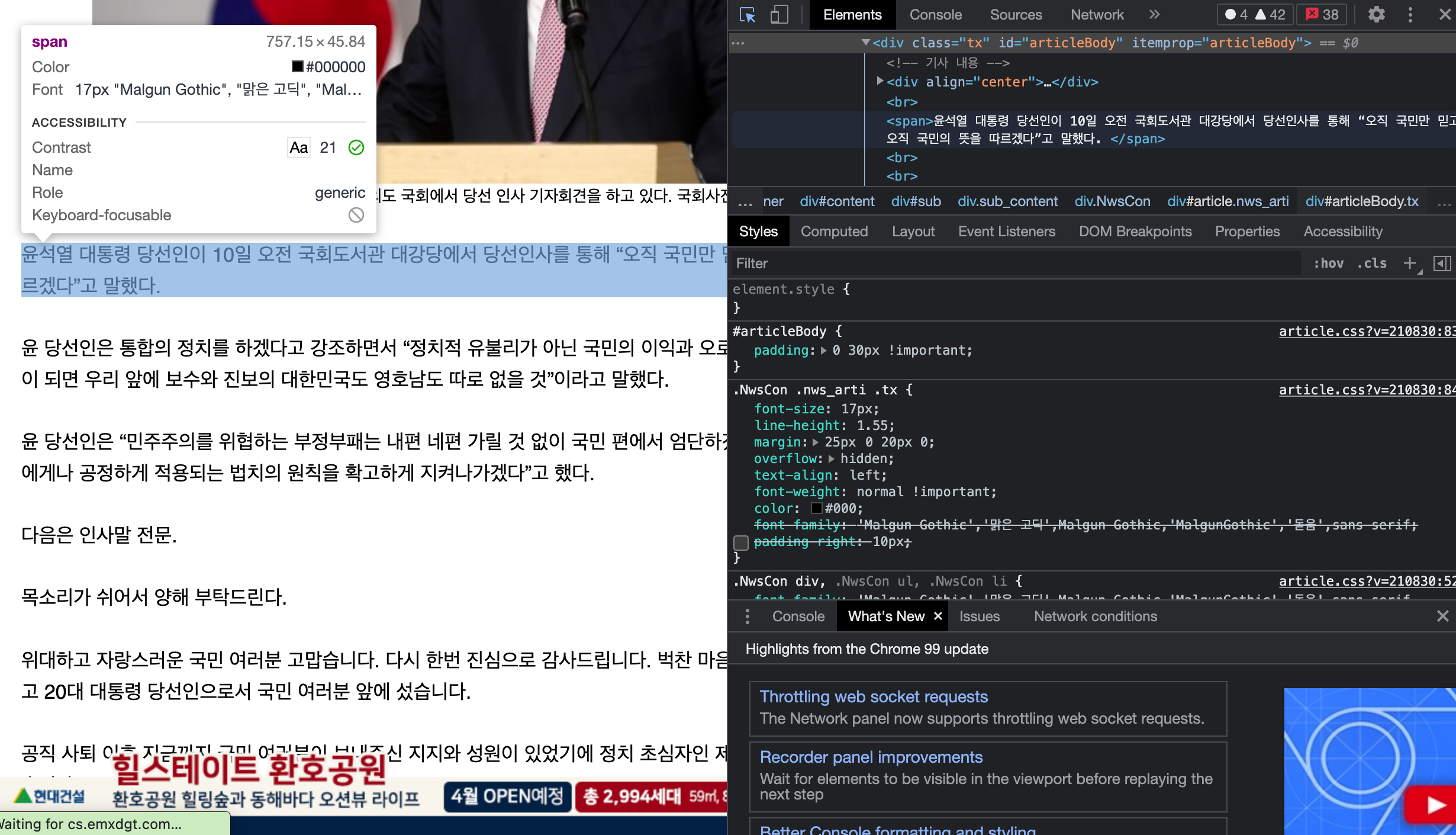

- 이번에는 본문만 크롤링 하도록 한다.

- 1개의 데이터만 가져와서 테스트를 해본다.

> url = kmib_df$URL[1]

> news = read_html(url, encoding = "EUC-KR")

> news

{html_document}<html xmlns="http://www.w3.org/1999/xhtml" xml:lang="ko">

[1] <head>\n<title>팬데믹의 비극… 무너지는 가정, 스러지는 아이들-국민일보</title>\n<meta http-equiv="Cont ...

[2] <body>\r\n<div id="wrap">\r\n\r\n<!-- header -->\r\n\r\n<script src="http://ww ...

- 여기에서 div 태그 안에 있는 class tx 하단에 텍스트가 있는 것을 확인할 수 있다.

- 해당 태그를 활용하여 본문만 가져오도록 한다.

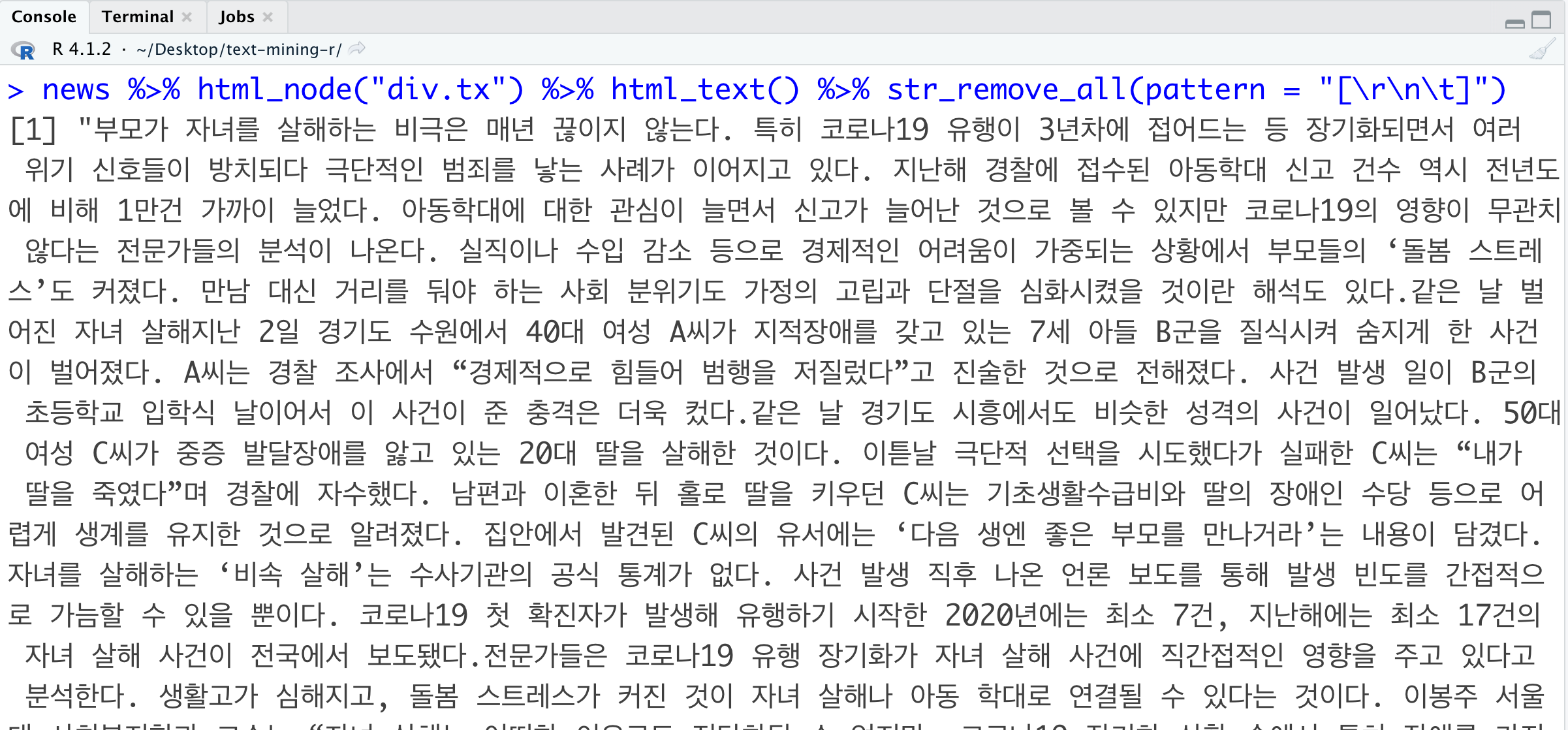

> news %>% html_node("div.tx") %>% html_text() %>% str_remove_all(pattern = "[\r\n\t]")

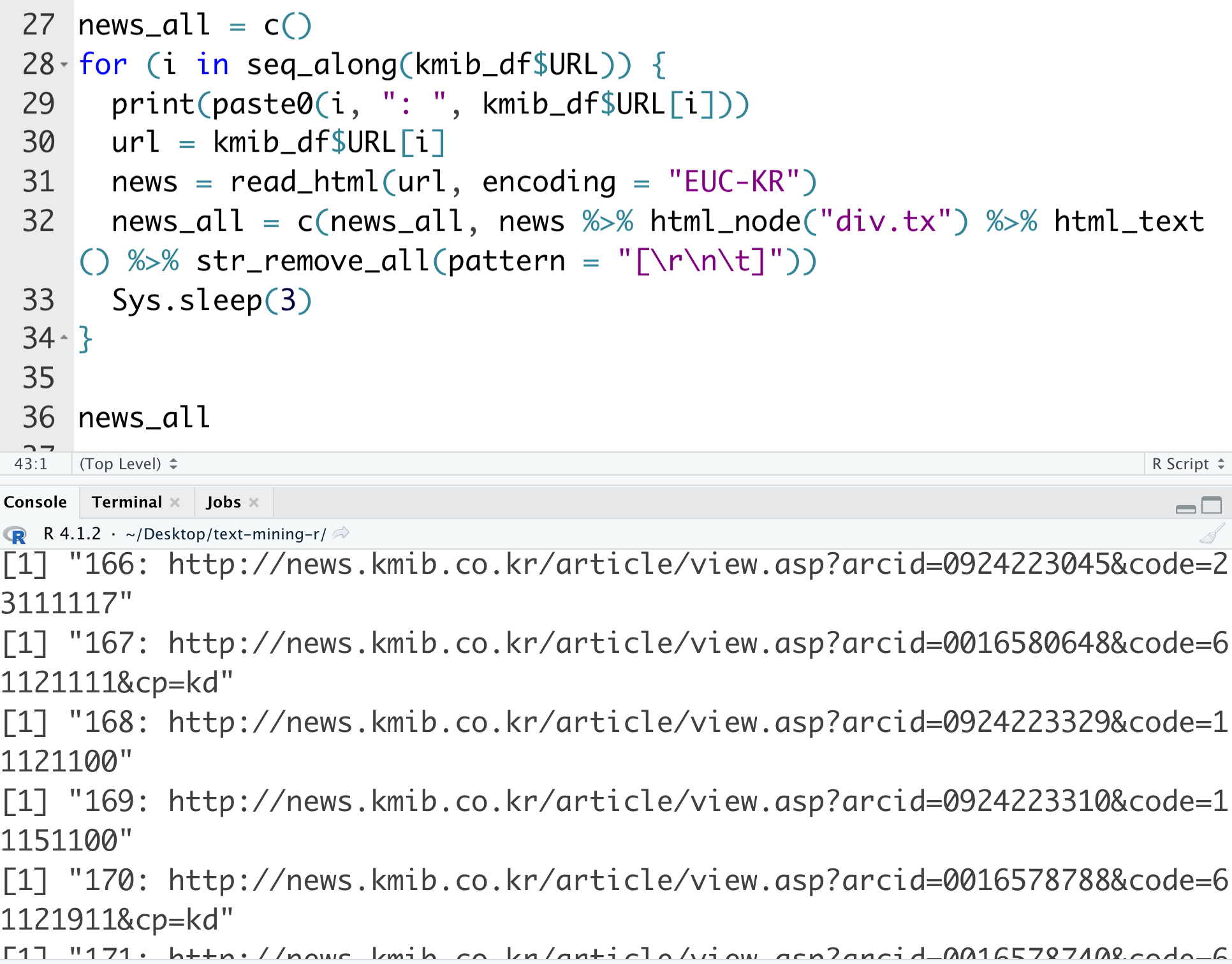

- 이제 위 코드를 응용하여 반복문을 작성하는 코드를 작성한다.

- Sys.sleep(3) 코드는 반복문 돌릴 시, 해당 사이트가 서버 과부하에 걸리지 않도록 조치를 하는 것이다.

- 몇몇 사이트에서는 클릭 이상 탐지로 여겨 해당 IP의 접근이 차단되는 경우도 있다.

> news_all = c()

> for (i in seq_along(kmib_df$URL)) {

+ print(paste0(i, ": ", kmib_df$URL[i]))

+ url = kmib_df$URL[i]

+ news = read_html(url, encoding = "EUC-KR")

+ news_all = c(news_all, news %>% html_node("div.tx") %>% html_text() %>% str_remove_all(pattern = "[\r\n\t]"))

+ Sys.sleep(3)

+ }

Step 04 - 웹 크롤링 본문 내용 저장 및 파일 내보내기

- 이번에는 본문만 크롤링 하도록 한다.

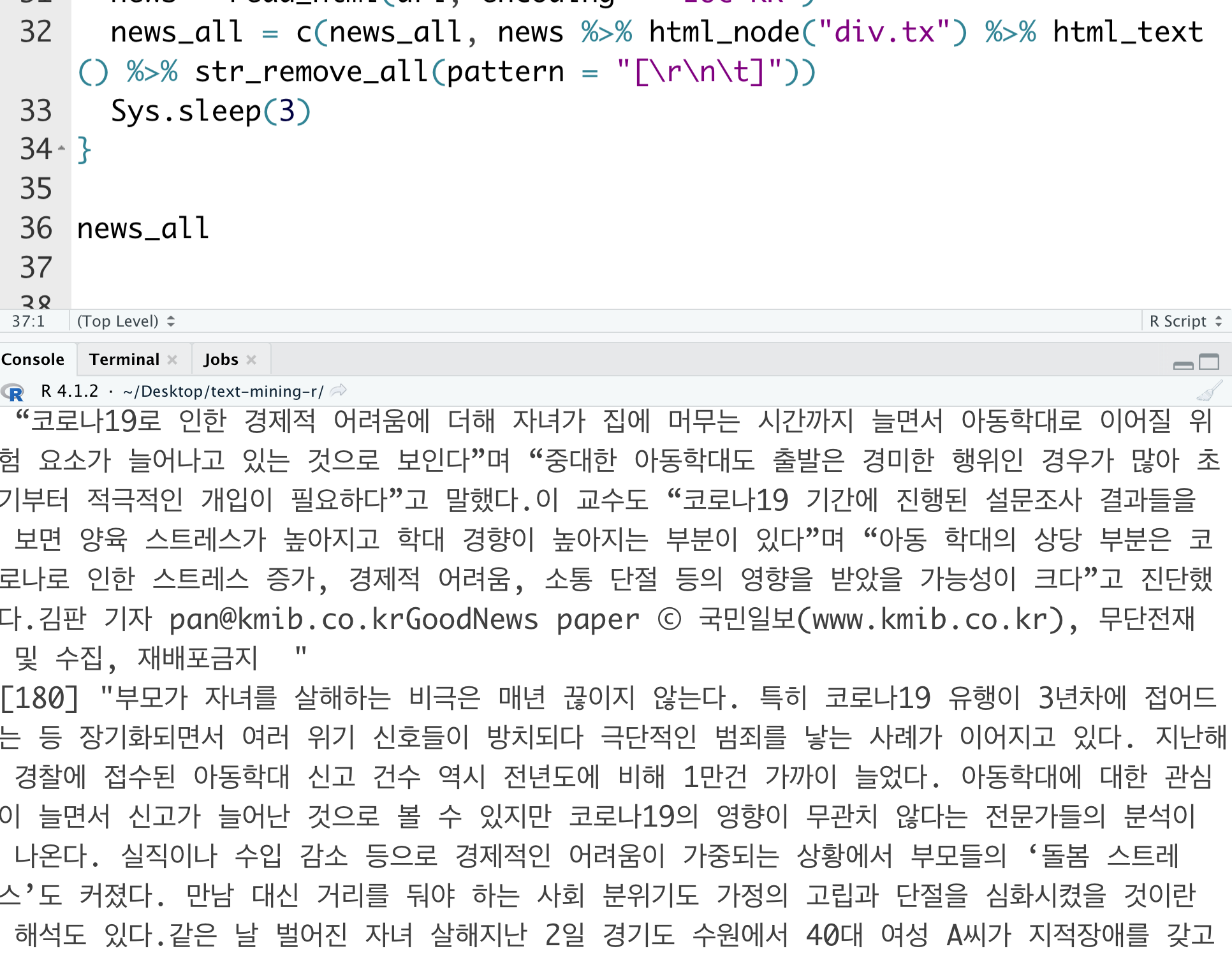

- 이제 결과물을 확인하도록 한다.

> news_all

- 이렇게 추출된 코드를 기존 국민일보 데이터셋에 추가하고 csv 파일로 저장한다.

kmib_df$본문 = news_all

write_csv(kmib_df, file = "data/국민일보.csv")